ספר היסוד שתורגם טרי מאת S. Khaikin (המהדורה האמריקאית השנייה של 1999 תורגמה) בהחלט טוען שהוא האירוע של 2006 בספרות הרוסית על נוירואינפורמטיקה. אך יש לציין שלמרות שהתרגום בוצע ללא טעויות ברורות, הערות שוליים והערות של המתרגמים לא יזיקו להבהרת הטרמינולוגיה (שכן ניתן לקרוא לאותו דבר בנוירואינפורמטיקה, סטטיסטיקה וזיהוי מערכת במילים שונות, הוא הכרחי או לצמצם את המונחים לאזור אחד, או לתת רשימות של מילים נרדפות - לא לכל הקוראים תהיה השקפה רחבה). ההערות יכולות לשקף גם את ההתקדמות בתחום של רשתות עצבים מלאכותיות שהתרחשה מאז פרסום המקור בשפה האנגלית. אני מקווה שהספר יהיה מבוקש ושיהיו שינויים כשהמהדורה תודפס מחדש. יתרה מכך, יש מספר לא מבוטל של שגיאות הקלדה בנוסחאות מתמטיות. עמוד זה מוקדש בעיקר לתיקון שגיאות הקלדה. אבל יש לציין שאני לא מבטיח את שלמות רשימת אי הדיוקים המופיעה כאן - קראתי את הספר "אלכסון", בהתקפים והתחלות מעלות משתנותתשומת לב, אז אולי פספסתי משהו (או עשיתי טעות בעצמי).

פרק 1

- עמ' 32 פסקה שנייה. רק כאן ניתן להבין את המילה "ביצועים" כמהירות הפעולה, כוחו של המחשב. בהמשך הספר, "ביצועים" פירושו דיוק, איכות העבודה של הרשת העצבית (למשל, בעמ' 73 בפסקה השנייה מלמטה).

- עמ' 35 עמ' 7. "יכולת יישום של VLSI" מתורגמת טוב יותר לא כ"מדרגיות", אלא כ"יכולת יישום יעילה ב-VLSI - מעגלים משולבים בקנה מידה גדול מאוד."

- עמ' 39 עמ' 7. המילה "ספייק" - "פליטה, דחף" במדעי המוח בשפה הרוסית מתורגמת לעתים קרובות למדי ובדרך כלל פשוט כ"ספייק".

- עמ' 49 כותרת הפסקה. אולי מונח טוב יותר יהיה "גרף מכוון" במקום "גרף מכוון".

- עמ' 76 פסקה שלישית. במקום קישור, כנראה צריך להיות קישור לספר של אשבי.

- מסקנה עמ' 99 1. יש להוסיף גם את המקרה של עמידה בו-זמנית של אותם תנאים ועם הסימן "

- P.105 פסקה 2. עליך להכניס את המילה "גלוי" לפני (גלוי).

פרק 2

- P.94 הערת שוליים 2. ככל הנראה ההתייחסות לא נכונה, מכיוון זה לא ספר והכותרת לא ממש מתאימה לו.

- עמ' 122 הפסקה האחרונה. צחקתי על הביטוי "דפורמציה של מבנה הנוירונים": עד שהאירוע החיצוני של זעזוע מוח יסתפק, אדם לא יזכור את האירוע הזה. סביר להניח, נטען שהזיכרון מתממש רק על ידי ניתוק כניסות סינפטיות (טרמינלים) מהמחושים של הדנדריטים או מעבר ממחוש אחד למשנהו (מונחים מאיור 1.2 בעמ' 40, שכן נתון זה מתאים להמחשה) . הָהֵן. המוח שלנו חי ונע.

- נוסחת P.129 (2.39). במקום איקסחייב להיות איקס.

- P.129 נוסחאות (2.40), (2.41), (2.44). הכתב העליון צריך להיות שבמקום M.

- עמ' 137 פסקה ראשונה ונוסחה (2.61). E צריך להיות בכתב נטוי. וגם בנוסחאות (2.64), (2.65), (2.67), (2.68) בעמ' 138.

- P.142 נוסחה (142). הוסף 0 אחרי החץ הראשון.

- עמ' 142 הפסקה האחרונה. לפני המילה האחרונההכנס "מינוס".

- עמ' 147 פסקה ראשונה. | ל|=ל. הָהֵן. מִשְׁתַנֶה לבצד ימין של הביטוי יש לציין בכתב נטוי (שכן הגרסה בספר מבלבלת בינו לבין אחד).

- נוסחת P.151 (2.90). הכנס לקו העליון אחרי הסד המתולתל ו.

- נוסחת C.151 (2.91). הכנס "ב" לפני נ.

- C.160 הפסקה האחרונה בהערת שוליים. יש להחליף את "לכמויות קטנות" ב"לכמויות גדולות".

פרק 3

- עמ' 173 איור 3.1. משתנים צריכים להינתן באותיות נטוי בהתאם לסימון המשמש בספר, כי משתנים אלה הם סקלרים.

- P.176 נוסחאות (3.5), (3.7). חייב להיות w* במקום w* .

- C.176 שורה אחרונה. סביר להניח שאתה צריך להתייחס, אם כי נושא זה יכול להיחשב גם באחד שצוין.

- עמ' 179 הערת שוליים. צריך להיות "נגזרת של f(w) ביחס ל-w"

- עמ' 180 שורה אחרונה לפני הערת השוליים. אולי עדיף לקחת במקום זאת, אבל ייתכן שהקישור שגוי.

- P.184 ביטוי ביניים בשורה העליונה של הנוסחה (3.30). במקום איקס(נ) צריך להיות איקס(אני)

- עמ' 200 פסקה אחרי נוסחה (3.59). צחקו על "אי השוויון של גוצ'י-שוורץ". צריך להיות אי השוויון של קאוצ'י-שוורץ, המוכר לכולם מהקורס באוניברסיטה.

- P.204 הפסקה הראשונה של סעיף 3.10 עוסקת בהפיכת מסווג בייסיאני למפריד ליניארי בסביבה גאוסית. הכוונה היא לתנאי שמטריצות השונות של שתי המחלקות זהות (יובא בסעיף בעמ' 207), אבל כשאני שומע את הביטוי "סביבה גאוסית" אני בדרך כלל זוכר את המצב המוכלל של שתי התפלגויות נורמליות עם קווריאנטיות שרירותית מטריצות, כאשר בייס עשוי לא להתדרדר למפריד ליניארי, אלא לתת משטח חלוקה ריבועי.

- נוסחת P.206 (3.77). לאחר מכן, במקום λ המצוין בנוסחה, Λ יודפס מספר פעמים בטקסט ובאיור 3.10.

- עמ' 216 משימה 3.11. את מה שניתן בגבול העליון של הסכום יש להעביר מתחת לסימן הסכום (ואפשר לשים את המינוס מול הסכום). גם בפסקה שאחרי נוסחה זו, במקום wט איקסחייב להיות wט איקס

פרק 4

הערה שלי על הפרק: סיוט, מתחיל ברשתות עצביות ושיטות אופטימיזציה, גם לאחר קריאת הפרק מספר פעמים וניסויים חוזרים (בכוונה או באקראי), לא סביר לתכנת נכון את האימון של רשת עצבית באמצעות ההפצה לאחור. שיטה. על ידי לפחות, כאשר בוחנים רק סטודנטים מאוניברסיטאות טכניות פרובינציאליות, אני מוכן להתווכח על זה עם סיכון גבוה למדי. המצגת עירבבה דברים נחוצים ומיותרים לכדי ערימה, מבלי לשים דגש ולסבך יתר על המידה את המצגת (נקיטת גישת "הכל או כלום" במקום הוספה שלב אחר שלב של נהלים). בנוסף הרבה אמפיריות. מדוע לא פשוט לשרטט את המתודולוגיה לחישוב השיפוע של פונקציה מורכבת (רשת עצבית בתוספת פונקציה אובייקטיבית על הפלט שלה, ובמידת הצורך, על פני מאפייני הרשת העצבית), ואז, כמו בפרק 6, להפנות את הקוראים לשיפוע שיטות אופטימיזציה ללא הגבלות (בפרק 6 ההתייחסות לשיטות תכנות ריבועיות), ומתווה מספר דוגמאות היסטוריות של גישות נכונות ושגויות לשימוש בשיפועים מחושבים ברשת מנקודת המבט של התיאוריה של אופטימיזציה של גרדיאנט ומקסום קצב ההתכנסות. (קצב למידה).

אילו דברים נוספים תרצה לראות בפרק (או בספר). ראשית, פונקציות אובייקטיביות שאינן ריבועים קטנים, במיוחד לאימון רשת מסווגת (לדוגמה, פונקציה צולבת אנטרופיה). שנית, הדגשה ברורה יותר של האפשרות של פונקציה אובייקטיבית המורכבת ממספר מונחים: שימוש בדוגמה של רגוליזציה לפי טיכונוב באמצעות מזעור מפורש, בנוסף לערך השגיאה עצמו, גם של שיפוע הריבוע הסקלרי של אותות הפלט של הרשת על ידי משקולות סינפסות (עבודה משותפת של LeCun ו-Drucker 1991-92), או באמצעות דוגמה של שיטת החיפוש Flat minina של Hochreiter ו-Schmidhuber, או בדוגמה של שיטת CLearning לניקוי אותות קלט ברשת מאת Andreas Weigend et al. שלישית, תיאור מפורט יותר של האפשרות לחישוב נגזרות שניות ברשת (עבודות מצוינות של LeCun ו-Drucker, שיטות המפורטות בסקירה). רביעית, תיאור מפורט יותר של שיטות לחישוב תוכן המידע-תועלת של אלמנטים ואותות שונים ברשת (כלומר, קביעת תוכן המידע של תשומות, אפשרות להפחית לא רק סינפסות באמצעות השיטות המתוארות בספר, אלא גם הפחתת נוירונים שלמים, ויש גם הרבה אפשרויות להפחתת סינפסות בשיטות אחרות). חמישית, יש אינדיקציה מפורשת (הקוראים לא יבינו זאת בעצמם) לגבי היכולת לחשב את השיפוע באמצעות אותות הכניסה של הרשת (כדי לפתור בעיות הפוכותעל רשתות עצביות שהוכשרו לפתור בעיה ישירה כדי להציג את שיטת ה-CLearning). בנוסף, עבור פרקים זה ופרקים אחרים שבהם מתעוררת משימת הלמידה בפיקוח, תאר ביתר פירוט את הרעיון של עקומות למידה עבור רשתות עצביות.

פרק 5

- עמ' 357 לאחר נוסחה (5.23). בהמשך בכמה עמודים העשוי להינתן באותיות נטוי או מודגש, ושינוי צורת הכתיבה הוא אקראי למדי. יותר נכון - באותיות נטוי, עבור E(F), E s (F), E c (F), E(F,h).

- נוסחת P.361 (5.31). במקום מנוי חחייב להיות ח .

- P.363 הפסקה האחרונה. "...בשילוב ליניארי..." במקום "...על ידי סופרפוזיציה לינארית...".

- נוסחת P.364 (5.43). הסר את 1/λ.

- נוסחת P.367 (5.59). σ במקום δ.

- עמ' 369 לאחר נוסחה (5.65). חייב להיות שוב" צירוף ליניארי" במקום "סופרפוזיציה לינארית".

- עמ' 373 שורה שלישית של הנוסחה (5.74). הכנס סוגרי פתיחה לפני השני ט אני .

- נוסחת P.382 (5.112). בגבול התחתון של הכמות, הוסף "לא שווה ל ק".

- עמ' 390 כותרת סעיף 5.12. במדע בשפה הרוסית, במקום "רגרסיית ליבה", משתמשים בדרך כלל במונחים "רגרסיה לא פרמטרית" (כך נקראת שיטת סטטיסטיקה זו ברוסית) או "רגרסיית ליבה" (אם מתורגמים "חזיתית").

- נוסחת P.393 (5.135). הכנס "...לכל..." כמו ב- (5.139) בעמוד הבא.

- עמ' 399 פסקה "אמצעית". "...אלגוריתם אשכול על ידי ק-מְמוּצָע...", אז לא תדלג עוד על המילה "ממוצע".

- P.403 רשימה לא ממוספרת. המחברים מסיקים מניסוי אחד מסקנות גלובליות מדי וחד-משמעיות מדי, אם כי הם מסכימים במידה רבה.

- P.404 הוא הפריט הראשון ברשימה. אני לא מבין, במיוחד בנוגע ל"השפעה על פרמטרי קלט". ולא יותר ערךλ, כך פחות השפעה של הנתונים באופן כללי על המאפיינים הסופיים של המודל.

- עמ' 408 פסקה ראשונה. הקישור אל מוטל בספק, אולי זה יעבוד.

- עמ' 408 שורה 6 של סעיף 2. "פונקציה בסיסית" במקום "פונקציה יסודית".

פרק 6

- עמ' 431 המשפט האחרון לפני סעיף 6.4. לא הבנתי את ה"טובה יותר" של הבחירה המוצעת באמצעות הממוצע המדגם (ונראה כמו לקבל את הבחירה הנכונה ב 0לא יתאפשר).

- נוסחת P.434 (6.35). אינדקס אניהאחרון איקסלא אמור להיות.

- P.435 נוסחאות לא ממוספרות במשפט מרסר. במקום ψ צריך להיות φ.

- עמ' 444 הערת שוליים. שם המשפחה הובר תורגם בעבר לרוסית כהובר, לא הבר (לדוגמה, תרגום ספרו בתקופת ברית המועצות: הובר, "חוסן בסטטיסטיקה").

פרק 7 (לא לגמרי)

- P.459 שורה שלישית מלמעלה. הגדרת המונח "אלגוריתם למידה חלש" ניתנת בעמ' 467 בפסקה השנייה מלמעלה.

- עמ' 459 פסקאות משנה לא ממוספרות בפסקה 2. המונח "רשת שער" כתרגום של המונח "רשת שער" מגושם מדי, אבל אין עדיין אפשרות אחרת (וטובה) ברוסית. עדיף כנראה להשתמש במונח "רשת משקל", שהוא אוניברסלי הן למקרה של מיתוג קשה (מכפילים של 0 או 1 עבור האות המבוקר) והן עבור בקרה רכה של מקדם הנחתה (מכפילים מהטווח).

- עמ' 463 עמ' 2. אנו מסירים את החלקיק "לא" מהמשפט הזה - הפיזור של האנסמבל קטן מהפיזור של פונקציות בודדות.

- עמ' 471 שורות ראשונות. "ביצועים" (אנחנו מזכירים לכם ש"ביצועים" מובנת כאן לא במובן של מהירות, אלא במובן של דיוק פתרון והכללה - ראה פירושנו בעמ' 32) של שיטת ההגברה המקורית תלויה גם בהתפלגויות נוצר במהלך פעולתו עבור מומחים שניים ואחרים.

- עמ' 472 טבלה 7.2 שורה אחרונה. חייב להיות וסְנַפִּיר( איקס)=…

בִּיבּלִיוֹגְרָפִיָה

- הרבה פעמים המילים יישום, קירוב, גישה, מיושם, תמיכה, מיפוי, ישימות, עליונה נכתבות באחד ע.

- . כתיבה נכונהניתן לראות את שמותיו של אחד המחברים.

- . שם המשפחה הנכון של מולר זהה לשם שלו.

- . מחבר ראשון - ב u ntine.

- . שוחרר באותו NIPS כמו .

- . אחרון המחברים נקרא נכון ב.

- . אנחנו צריכים חלשים במקום שבוע.

- . המחבר האחרון נקרא נכון ב.

- . ראשון - לנדא u.

- . זהו פרק בספר.

- . ש ö lkopf.

- . בכותרת - "...bia סמונח". הוא מאוית נכון בשכפול.

- . בכותרת - "...גמ עַל".

- . חזור.

ב תיארנו הכי הרבה מאפיינים פשוטיםנוירונים רשמיים. דיברנו על העובדה שמוסיף הסף משחזר בצורה מדויקת יותר את אופיו של ספייק בודד, והאדף הליניארי מאפשר לך לדמות את התגובה של נוירון, המורכב מסדרה של דחפים. הם הראו שניתן להשוות את הערך בפלט של מוסיף ליניארי עם התדירות של קוצים מעוררים של נוירון אמיתי. כעת נבחן את התכונות הבסיסיות שיש לנוירונים רשמיים כאלה.

פילטר Hebb

בהמשך, נתייחס לעתים קרובות למודלים של רשתות עצביות. באופן עקרוני, כמעט כל המושגים הבסיסיים מהתיאוריה של רשתות עצבים קשורים ישירות למבנה המוח האמיתי. האדם, שעמד בפני בעיות מסוימות, מצא עיצובים רבים של רשתות עצביות מעניינים. האבולוציה, שעברה את כל המנגנונים העצביים האפשריים, בחרה את כל מה שהתברר כמועיל עבורה. זה לא צריך להיות מפתיע שעבור מודלים רבים שהומצאו על ידי האדם, ניתן למצוא אבות טיפוס ביולוגיים ברורים. מכיוון שהנרטיב שלנו אינו מכוון להציג בפירוט את התיאוריה של רשתות עצביות, ניגע רק ברוב נקודות כלליותהכרחי כדי לתאר את הרעיונות העיקריים. להבנה מעמיקה יותר, אני ממליץ בחום לפנות לספרות מיוחדת. עבורי, ספר הלימוד הטוב ביותר על רשתות עצביות הוא "רשתות עצביות" של סיימון חייקין. קורס שלם" (חיקין, 2006).מודלים רבים של רשתות עצביות מבוססים על כלל הלמידה ההבביאנית הידועה. הוא הוצע על ידי הפיזיולוגי דונלד האב ב-1949 (Hebb, 1949). בפירוש מעט רופף, יש לזה משמעות פשוטה מאוד: יש לחזק קשרים בין נוירונים שיורים יחד, קשרים בין נוירונים שיורים באופן עצמאי צריכים להיחלש.

ניתן לכתוב את מצב הפלט של המוסיף הליניארי:

אם אנחנו מתחילים את הערכים ההתחלתיים של המשקולות בערכים קטנים ומספקים תמונות שונות כקלט, אז שום דבר לא מונע מאיתנו לנסות לאמן את הנוירון הזה לפי הכלל של Hebb:

איפה נ- שלב זמן דיסקרטי, - פרמטר קצב למידה.

עם הליך זה, אנו מגדילים את המשקל של אותם כניסות שאליהם מופעל האות, אך אנו עושים זאת ככל שתגובה חזקה יותר, פעילה יותר של הנוירון הלומד עצמו. אם אין תגובה, אז למידה לא מתרחשת.

נכון, משקלים כאלה יגדלו ללא הגבלה, כך שניתן ליישם נורמליזציה לייצוב. לדוגמה, חלקו באורך הווקטור המתקבל מהמשקולות הסינפטיות ה"חדשות".

עם למידה כזו, משקלים מחולקים מחדש בין סינפסות. קל יותר להבין את מהות החלוקה מחדש אם עוקבים אחר השינוי במשקלים בשני שלבים. ראשית, כאשר נוירון פעיל, אותן סינפסות שמקבלות אות מקבלות תוסף. המשקולות של סינפסות ללא אות נשארות ללא שינוי. נורמליזציה כללית מפחיתה את המשקל של כל הסינפסות. אך יחד עם זאת, סינפסות ללא אותות מאבדות בהשוואה לערכן הקודם, וסינפסות עם אותות מחלקות מחדש את ההפסדים הללו ביניהן.

כלל Hebb הוא לא יותר מיישום של שיטת הירידה בשיפוע לאורך משטח השגיאה. בעיקרו של דבר, אנו מאלצים את הנוירון להסתגל לאותות המסופקים, בכל פעם מעבירים את משקלו לכיוון המנוגד לשגיאה, כלומר לכיוון האנטי-גרדיאנט. כדי שירידה בשיפוע תוביל אותנו לקיצוניות מקומית מבלי לחרוג ממנה, מהירות הירידה חייבת להיות נמוכה למדי. מה שבלימוד העברית נלקח בחשבון על ידי הקטנות של הפרמטר.

הקטנות של פרמטר קצב הלמידה מאפשרת לנו לשכתב את הנוסחה הקודמת כסדרה ב:

אם נזרוק מונחים מהסדר השני ומעלה, נקבל את כלל הלמידה של אוג'ה (Oja, 1982):

התוסף החיובי אחראי על למידה העברית, והתוסף השלילי אחראי על היציבות הכללית. הקלטה בצורה זו מאפשרת לך להרגיש כיצד ניתן ליישם אימון כזה בסביבה אנלוגית ללא שימוש בחישובים, הפועלת רק עם קשרים חיוביים ושליליים.

לכן, לאימון פשוט במיוחד יש תכונה מדהימה. אם נצמצם בהדרגה את קצב הלמידה, משקלי הסינפסות של הנוירון המאומן יתכנסו לערכים כאלה שהתפוקה שלו תתחיל להתאים למרכיב העיקרי הראשון, שיתקבל אם היינו מיישמים את הליכי ניתוח הרכיבים העיקריים המתאימים. הנתונים שסופקו. עיצוב זה נקרא פילטר Hebb.

לדוגמה, בואו נזין תמונת פיקסל לכניסה של נוירון, כלומר, נשייך נקודת תמונה אחת לכל סינפסה של הנוירון. נספק רק שתי תמונות לכניסת הנוירון - תמונות של קווים אנכיים ואופקיים העוברים במרכז. שלב למידה אחד - תמונה אחת, קו אחד, אופקי או אנכי. אם התמונות האלה ממוצעות, אתה מקבל הצלבה. אבל תוצאת הלמידה לא תהיה דומה לממוצע. זו תהיה אחת השורות. זה שיופיע לעתים קרובות יותר בתמונות שנשלחו. הנוירון לא ידגיש מיצוע או צומת, אלא את הנקודות המתרחשות לרוב יחד. אם התמונות מורכבות יותר, ייתכן שהתוצאה לא תהיה כל כך ברורה. אבל זה תמיד יהיה המרכיב העיקרי.

אימון נוירון מוביל לכך שתמונה מסוימת מודגשת (מסוננת) על סולמותיה. כאשר ניתן אות חדש, ככל שההתאמה בין האות להגדרות המשקל מדויקת יותר, כך תגובת הנוירון גבוהה יותר. נוירון מאומן יכול להיקרא נוירון גלאי. במקרה זה, התמונה המתוארת לפי סולמותיה נקראת בדרך כלל גירוי אופייני.

רכיבים עיקריים

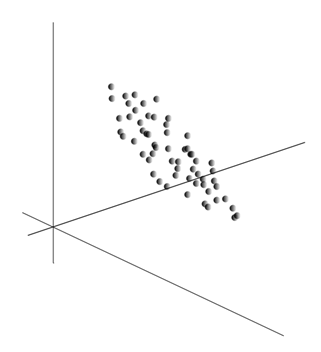

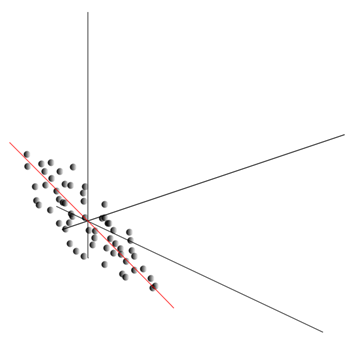

עצם הרעיון של שיטת הרכיבים העיקריים הוא פשוט וגאוני. נניח שיש לנו רצף של אירועים. אנו מתארים כל אחד מהם באמצעות השפעתו על החיישנים שאיתם אנו תופסים את העולם. נניח שיש לנו חיישנים שמתארים תכונות. כל האירועים עבורנו מתוארים על ידי וקטורים של מימד. כל רכיב של וקטור כזה מציין את הערך של התכונה המתאימה. יחד הם יוצרים משתנה אקראי איקס . אנו יכולים לתאר אירועים אלה כנקודות במרחב-ממדי, כאשר הצירים יהיו הסימנים שאנו צופים בהם.

ממוצע ערכים נותן את הציפייה המתמטית למשתנה אקראי איקס, מסומן כ-E( איקס). אם נרכז את הנתונים כך ש-E( איקס)=0, אז ענן הנקודות יתרכז סביב המקור.

הענן הזה עשוי להיות מוארך לכל כיוון. לאחר שניסיתי הכל כיוונים אפשריים, נוכל למצוא אחד שלאורכו פיזור הנתונים יהיה מקסימלי.

אז, כיוון זה מתאים למרכיב העיקרי הראשון. המרכיב העיקרי עצמו נקבע על ידי וקטור יחידה הנובע מהמקור וחופף לכיוון זה.

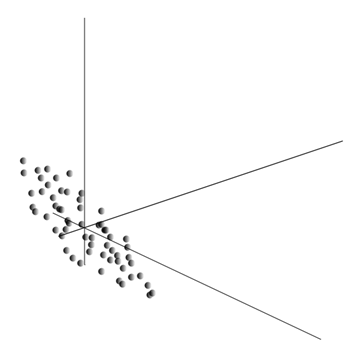

לאחר מכן, נוכל למצוא כיוון נוסף, מאונך לרכיב הראשון, כך שגם לאורכו הפיזור הוא מקסימלי בין כל הכיוונים הניצבים. לאחר שמצאנו אותו, אנו מקבלים את הרכיב השני. לאחר מכן נוכל להמשיך בחיפוש, להגדיר את התנאי שעלינו לחפש בין הכיוונים המאונכים לרכיבים שכבר נמצאו. אם הקואורדינטות הראשוניות היו בלתי תלויות באופן ליניארי, אז נוכל לעשות זאת פעם אחת עד שממד המרחב מסתיים. לפיכך, נקבל רכיבים אורתוגונליים הדדיים, מסודרים לפי אחוז השונות בנתונים שהם מסבירים.

באופן טבעי, המרכיבים העיקריים המתקבלים משקפים את הדפוסים הפנימיים של הנתונים שלנו. אבל יש מאפיינים פשוטים יותר שמתארים גם את מהות הדפוסים הקיימים.

נניח שיש לנו n אירועים בסך הכל. כל אירוע מתואר על ידי וקטור. רכיבים של וקטור זה:

עבור כל סימן, ניתן לרשום כיצד הוא בא לידי ביטוי בכל אחד מהאירועים:

עבור כל שני מאפיינים עליהם מתבסס התיאור, ניתן לחשב ערך המראה את מידת הביטוי המשותף שלהם. כמות זו נקראת שיתופיות:

הוא מראה כיצד סטיות מהערך הממוצע של אחד המאפיינים חופפות לביטוי עם סטיות דומות של מאפיין אחר. אם הערכים הממוצעים של המאפיינים שווים לאפס, השונות לובשת את הצורה:

אם נתקן את השונות עבור סטיות התקן הגלומות במאפיינים, נקבל מקדם מתאם ליניארי, הנקרא גם מקדם המתאם של פירסון: ![]()

למקדם המתאם יש תכונה יוצאת דופן. זה לוקח ערכים מ-1 עד 1. יתר על כן, 1 פירושו מידתיות ישירה של שתי כמויות, ו-1 מציין את הקשר הליניארי ההפוך שלהם.

מכל השונות הצמדית של תכונות, נוכל ליצור מטריצת שיתופיות, שכפי שניתן לראות בקלות, היא הציפייה המתמטית של המוצר: ![]()

אז מסתבר שעבור המרכיבים העיקריים נכון הדבר הבא:

כלומר, המרכיבים העיקריים, או כפי שהם נקראים גם גורמים, הם וקטורים עצמיים של מטריצת המתאם. הם תואמים לערכים עצמיים. יחד עם זאת, כמה שיותר ערך עצמי, ככל שאחוז השונות המוסבר על ידי גורם זה גדול יותר.

הכרת כל המרכיבים העיקריים, לכל אירוע שהוא מימוש איקס

, נוכל לרשום את תחזיותיו על המרכיבים העיקריים:

לפיכך, ניתן לייצג את כל האירועים הראשוניים בקואורדינטות חדשות, הקואורדינטות של המרכיבים העיקריים:

ככלל, מבחינים בין הליך חיפוש מרכיבים עיקריים לבין הליך מציאת בסיס מגורמים וסיבובו לאחר מכן, דבר המקל על פרשנות הגורמים, אולם מאחר שהליכים אלו קרובים אידיאולוגית ונותנים תוצאה דומה, אנו יקרא לשניהם ניתוח גורמים.

מאחורי ההליך הפשוט למדי של ניתוח גורמים מסתתרת משמעות עמוקה מאוד. העובדה היא שאם מרחב התכונות הראשוניות הוא מרחב הנצפה, אז גורמים הם מאפיינים שלמרות שהם מתארים את תכונות העולם הסובב, במקרה הכללי (אם הם לא חופפים לתכונות הנצפות) הן ישויות נסתרות. כלומר, ההליך הפורמלי של ניתוח גורמים מאפשר לנו לעבור מתופעות נצפות לגילוי תופעות, אמנם בלתי נראות ישירות, אך בכל זאת קיימות בעולם הסובב.

ניתן להניח שהמוח שלנו משתמש באופן פעיל בבחירת הגורמים כאחד מההליכים להבנת העולם הסובב אותנו. על ידי זיהוי גורמים, אנו מקבלים הזדמנות לבנות תיאורים חדשים של מה שקורה לנו. הבסיס לתיאורים החדשים הללו הוא הביטוי במתרחש של אותן תופעות המתאימות לגורמים שזוהו.

הרשו לי להסביר מעט את מהות הגורמים ברמה היומיומית. נניח שאתה מנהל משאבי אנוש. אנשים רבים מגיעים אליכם, ולכל אחד מהם אתם ממלאים טופס מסוים, שבו אתם רושמים נתונים שונים נצפים על המבקר. לאחר עיון בהערות שלך מאוחר יותר, ייתכן שתגלה שלחלק מהגרפים יש קשר מסוים. לדוגמה, תספורות גברים יהיו קצרות יותר בממוצע משל נשים. סביר להניח שתפגשו קרחים רק בקרב גברים, ורק נשים ילבשו שפתון. אם מוחל על נתונים אישיים ניתוח גורמים, אז מגדר יהיה אחד הגורמים שמסבירים מספר דפוסים בו-זמנית. אבל ניתוח גורמים מאפשר לך למצוא את כל הגורמים המסבירים את המתאמים במערך נתונים. המשמעות היא שמלבד הגורם המגדרי, שנוכל להבחין בו, יהיו גם אחרים, כולל גורמים מרומזים, בלתי נצפים. ואם מגדר מופיע במפורש בשאלון, אז אחר גורם חשוביישאר בין השורות. על ידי הערכת יכולתם של אנשים לבטא את מחשבותיהם, הערכת הצלחתם בקריירה, ניתוח ציוני התעודה שלהם וסימנים דומים, תגיעו למסקנה שיש דירוג כוללאינטליגנציה אנושית, שאינה רשומה במפורש בשאלון, אך מסבירה רבות מנקודותיה. הערכת מודיעין היא מה שזה גורם נסתר, מרכיב עיקרי בעל אפקט הסברתי גבוה. איננו צופים ברכיב זה במפורש, אך אנו רושמים סימנים המתואמים אליו. לאחר ניסיון חיים, אנו יכולים לגבש באופן לא מודע רעיון של האינטליגנציה של בן שיחו בהתבסס על מאפיינים מסוימים. ההליך שבו משתמש המוח שלנו במקרה זה הוא, בעצם, ניתוח גורמים. בהתבוננות כיצד תופעות מסוימות מופיעות יחדיו, המוח, תוך שימוש בהליך פורמלי, מזהה גורמים כהשתקפות של דפוסים סטטיסטיים יציבים הגלומים בעולם הסובב אותנו.

זיהוי מכלול גורמים

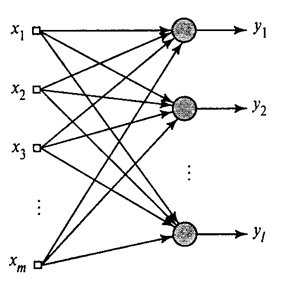

הראינו כיצד מסנן Hebb בוחר את הרכיב הראשי הראשון. מסתבר שבעזרת רשתות עצביות ניתן להשיג בקלות לא רק את הרכיבים הראשונים, אלא גם את כל שאר הרכיבים. ניתן לעשות זאת, למשל, בדרך הבאה. בוא נניח שיש לנו תכונות קלט. בואו ניקח נוירונים ליניאריים, שם .

אלגוריתם Hebb כללי(חיקין, 2006)

נאמן את הנוירון הראשון כמסנן Hebb כך שיבחר את הרכיב העיקרי הראשון. אבל נאמן כל נוירון עוקב על אות שממנו נשלל את ההשפעה של כל הרכיבים הקודמים.

פעילות עצבית במהלך צעד נמוגדר כ

והתיקון למשקולות הסינופטיות הוא כמו

איפה מ-1 ל-, ומ-1 ל-.

עבור כל הנוירונים, זה נראה כמו למידה בדומה למסנן Hebb. ההבדל היחיד הוא שכל נוירון עוקב לא רואה את כל האות, אלא רק את מה שהנוירונים הקודמים "לא ראו". עקרון זה נקרא הערכה מחדש. אנו למעשה משחזרים את האות המקורי מקבוצה מוגבלת של רכיבים ומכריחים את הנוירון הבא לראות רק את השאר, את ההבדל בין האות המקורי לזה המשוחזר. אלגוריתם זה נקרא אלגוריתם Hebb המוכלל.

מה שלא לגמרי טוב באלגוריתם Hebb המוכלל הוא שהוא "חישובי" מדי באופיו. יש להזמין נוירונים, ולספור את פעילותם ברצף. זה לא מאוד תואם את עקרונות הפעולה של קליפת המוח, שבה כל נוירון, למרות שהוא מקיים אינטראקציה עם האחרים, פועל באופן אוטונומי, ושם אין "מעבד מרכזי" מוגדר בבירור שיקבע את רצף האירועים הכולל. מסיבות אלה, אלגוריתמים הנקראים אלגוריתמי דקורלציה נראים אטרקטיביים יותר.

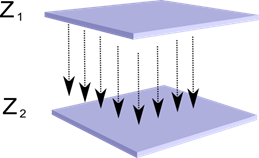

בואו נדמיין שיש לנו שתי שכבות של נוירונים Z 1 ו- Z 2. פעילות הנוירונים בשכבה הראשונה יוצרת תמונה מסוימת, המוקרנת לאורך האקסונים אל השכבה הבאה.

הקרנה של שכבה אחת על גבי שכבה אחרת

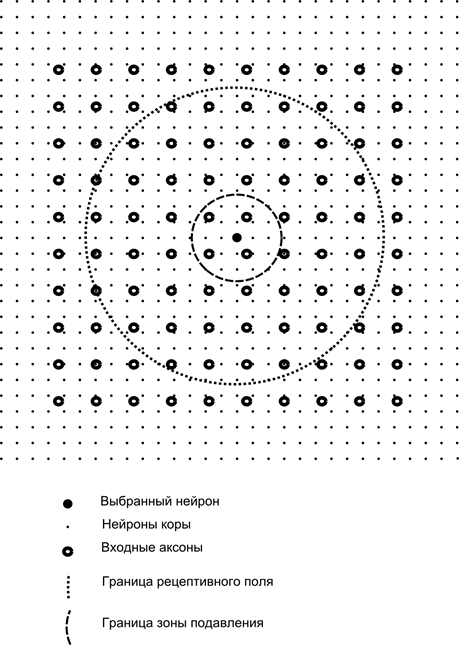

כעת דמיינו שלכל נוירון מהשכבה השנייה יש קשרים סינפטיים עם כל האקסונים המגיעים מהשכבה הראשונה, אם הם נופלים בגבולות שכונה מסוימת של הנוירון הזה (איור למטה). אקסונים הנכנסים לאזור כזה יוצרים את השדה הקליטה של הנוירון. השדה הקליטה של נוירון הוא אותו קטע של פעילות כללית שזמינה לו להתבוננות. כל השאר פשוט לא קיים עבור הנוירון הזה.

בנוסף לשדה הקליטה של הנוירון, נציג אזור מעט קטן יותר, אותו נקרא אזור הדיכוי. בואו נחבר כל נוירון עם השכנים שלו שנופלים לאזור הזה. קשרים כאלה נקראים לרוחב או, בהתאם לטרמינולוגיה המקובלת בביולוגיה, לרוחב. בואו נהפוך את החיבורים הצדדיים למעכבים, כלומר, נפחית את פעילות הנוירונים. ההיגיון של עבודתם הוא שנוירון פעיל מעכב את הפעילות של כל אותם נוירונים שנופלים לאזור העיכוב שלו.

קשרים מעוררים ומעכבים יכולים להיות מופצים בקפדנות עם כל האקסונים או הנוירונים בגבולות האזורים המתאימים, או שהם יכולים להיות מוגדרים באופן אקראי, למשל, עם מילוי צפוף של מרכז מסוים וירידה אקספוננציאלית בצפיפות הקשרים כאחד. מתרחק ממנו. מילוי רציף קל יותר למידול; התפלגות אקראית היא יותר אנטומית מנקודת המבט של ארגון הקשרים בקליפת המוח האמיתית.

ניתן לכתוב את פונקציית פעילות הנוירונים:

היכן נמצאת הפעילות הסופית, האם קבוצת האקסונים נופלת לאזור הקליטה של הנוירון הנבחר, היא קבוצת הנוירונים לאזור הדיכוי שבו נופל הנוירון הנבחר, ומהווה עוצמתה של העיכוב הרוחבי המקביל, אשר לוקח ערכים שליליים.

פונקציית פעילות זו היא רקורסיבית, מכיוון שפעילות הנוירונים מתבררת כתלויה זה בזה. זה מוביל לעובדה שחישובים מעשיים מבוצעים באופן איטרטיבי.

אימון משקולות סינפטיות נעשה בדומה למסנן Hebb:

משקלים רוחביים לומדים על פי הכלל האנטי-הבי, ומגבירים את העיכוב בין נוירונים "דומים":

המהות של עיצוב זה היא שלמידה העברית צריכה להוביל להקצאה על סולמות הנוירון של ערכים התואמים לגורם העיקרי הראשון המאפיין את הנתונים שסופקו. אבל נוירון מסוגל ללמוד בכיוון של כל גורם רק אם הוא פעיל. כאשר נוירון מתחיל להפריש גורם ובהתאם לכך, להגיב אליו, הוא מתחיל לחסום את פעילות הנוירונים הנופלים לאזור הדיכוי שלו. אם מספר נוירונים מתחרים על הפעלה, אז תחרות הדדית מובילה לכך שהנוירון החזק ביותר מנצח, תוך דיכוי כל האחרים. לנוירונים אחרים אין ברירה אלא ללמוד באותם רגעים שאין איתם שכנים בקרבת מקום. פעילות גבוהה. לפיכך, מתרחשת דקורלציה, כלומר, כל נוירון בתוך האזור, שגודלו נקבע לפי גודל אזור הדיכוי, מתחיל להדגיש את הגורם שלו, אורתוגונלי לכל האחרים. אלגוריתם זה נקרא אלגוריתם החילוץ של רכיבים אדפטיביים (APEX) (Kung S., Diamantaras K.I., 1990).

הרעיון של עיכוב רוחב קרוב ברוחו למוכר דגמים שוניםעקרון "המנצח לוקח הכל", המאפשר גם עיטור של האזור בו מחפשים את הזוכה. עיקרון זה משמש, למשל, בניאוקוגניטרון פוקושימה, המפות המתארגנות את עצמו של קוהנן, ועיקרון זה משמש גם באימון הזיכרון הזמני ההיררכי הידוע של ג'ף הוקינס.

אתה יכול לקבוע את המנצח השוואה פשוטהפעילות נוירונים. אבל חיפוש כזה, המיושם בקלות במחשב, אינו עולה בקנה אחד עם אנלוגיות לקורטקס האמיתי. אבל אם תגדיר את המטרה לעשות הכל ברמת האינטראקציה בין נוירונים מבלי לערב אלגוריתמים חיצוניים, אז אותה תוצאה יכולה להיות מושגת אם בנוסף לעיכוב רוחבי של שכנים, לנוירון יש משוב חיובי שמרגש אותו. טכניקה זו למציאת מנצח משמשת, למשל, ברשתות תהודה אדפטיבית של גרוסברג.

אם האידיאולוגיה של רשת עצבית מאפשרת זאת, אז השימוש בכלל "המנצח לוקח הכל" נוח מאוד, שכן חיפוש הפעילות המקסימלית הוא הרבה יותר פשוט מאשר חישוב איטרטיבי של פעילויות תוך התחשבות בעיכוב הדדי.

הגיע הזמן לסיים את החלק הזה. התברר שזה די ארוך, אבל ממש לא רציתי לפצל את הנרטיב שהיה קשור במשמעות. אל תתפלאו מ-KDPV, התמונה הזו הייתה קשורה עבורי גם לבינה מלאכותית וגם לגורם העיקרי.

מאמר זה מכיל חומרים - בעיקר ברוסית - למחקר בסיסי של רשתות עצביות מלאכותיות.

רשת עצבים מלאכותית, או ANN - מודל מתמטי, כמו גם התגלמות התוכנה או החומרה שלו, הבנויה על עקרון הארגון והתפקוד של רשתות עצביות ביולוגיות - רשתות תאי עצביםיצור חי. המדע של רשתות עצביות קיים די הרבה זמן, אבל זה בדיוק בקשר עם ההישגים האחרוניםעם ההתקדמות המדעית והטכנולוגית, תחום זה מתחיל לצבור פופולריות.

ספרים

בואו נתחיל את הבחירה עם דרך קלאסיתלימוד - בעזרת ספרים. בחרנו ספרים בשפה הרוסית עם מספר רב של דוגמאות:

- וסרמן, טכנולוגיית נוירומחשב: תיאוריה ופרקטיקה. 1992

הספר מציג בצורה נגישה לציבור את היסודות של בניית מחשבים עצביים. מתוארים המבנה של רשתות עצביות ואלגוריתמים שונים לתצורתן. פרקים נפרדים מוקדשים ליישום רשתות עצביות. - S. Khaikin, רשתות עצביות: קורס מלא. 2006

הפרדיגמות העיקריות של רשתות עצבים מלאכותיות נדונות כאן. החומר המוצג מכיל הצדקה מתמטית קפדנית לכל פרדיגמות הרשת העצבית, מומחש בדוגמאות, תיאורים של ניסויי מחשב, ומכיל רבות בעיות מעשיות, כמו גם ביבליוגרפיה נרחבת.

ד פורסיית', ראיית מחשב. גישה מודרנית. 2004

ראייה ממוחשבת היא אחד התחומים הפופולריים ביותר בשלב זה של פיתוח טכנולוגיות מחשב דיגיטליות גלובליות. זה נדרש בייצור, בקרת רובוטים, אוטומציה של תהליכים, יישומים רפואיים וצבאיים, מעקב לוויינים ויישומי מחשב אישי כגון אחזור תמונות דיגיטליות.

וִידֵאוֹ

אין דבר נגיש ומובן יותר מלמידה חזותית באמצעות וידאו:

- כדי להבין מהי למידת מכונה באופן כללי, עיין כאן שתי ההרצאות הללומ-Yandex ShAD.

- מבואלעקרונות הבסיסיים של עיצוב רשתות עצביות - מצוין להמשך ההיכרות עם רשתות עצביות.

- קורס הרצאהעל הנושא "ראיית מחשב" ממכונות המחשוב של אוניברסיטת מוסקבה. ראייה ממוחשבת היא התיאוריה והטכנולוגיה של יצירת מערכות מלאכותיות המזהות ומסווגות אובייקטים בתמונות ובסרטונים. הרצאות אלו יכולות להיחשב כמבוא למדע מעניין ומורכב זה.

משאבים חינוכיים וקישורים שימושיים

- פורטל בינה מלאכותית.

- מעבדה "אני אינטליגנציה".

- רשתות עצביות במטלב.

- רשתות עצביות בפייתון (אנגלית):

- סיווג טקסט באמצעות ;

- פשוט.

- רשת עצבית ב-.

סדרת הפרסומים שלנו בנושא

פרסמנו בעבר קורס #neuralnetwork@tprogerברשתות עצביות. ברשימה זו, הפרסומים מסודרים לפי סדר הלימוד לנוחיותכם.